Las expresiones faciales podrían ayudar a ampliar las opciones de accesibilidad de VR y AR

Crédito: Universidad de Glasgow

Un nuevo estudio sobre cómo las computadoras pueden controlarse con precisión utilizando solo expresiones faciales podría ayudar a que las tecnologías de realidad aumentada (AR) y realidad virtual (VR) sean más accesibles para las personas que viven con discapacidades.

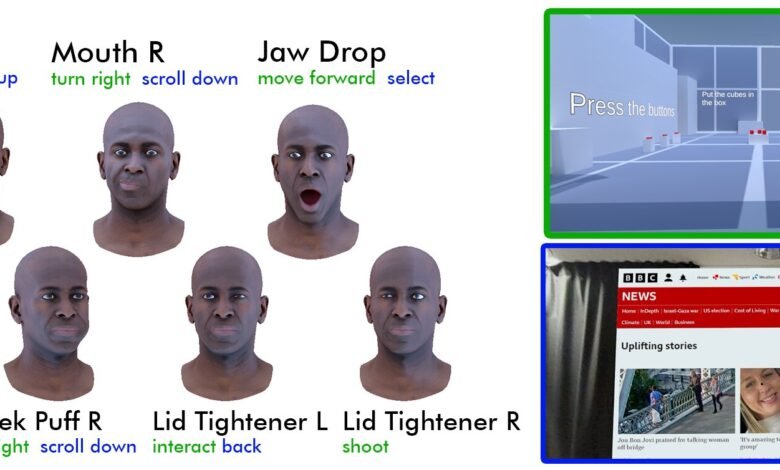

Investigadores de la Universidad de Glasgow y la Universidad de St. Gallen en Suiza descubrieron que siete movimientos faciales simples podrían ser reconocidos de manera confiable por los auriculares Meta’s Quest Pro, lo que permite a los usuarios controlar un juego de realidad virtual y navegar por páginas web en un entorno AR.

Los resultados podrían permitir a los auriculares VR ampliamente disponibles para ofrecer a las personas que viven con discapacidades nuevas formas de interactuar con las computadoras, así como ampliar las opciones de control manos libres disponibles para cada usuario.

Durante el estudio, que se presentará como un artículo en la conferencia CHI 2025 a finales de este mes, los investigadores pidieron a 20 voluntarios no discapacitados que intenten mover sus rostros para que coincidan con las 53 expresiones ya reconocidas por el software de Quest Pro.

Estas expresiones, llamadas unidades de acción facial o faus, generalmente son recogidas por las cámaras a bordo del auricular para traducir las expresiones faciales del mundo real en las virtuales en entornos en línea.

Se pidió a los voluntarios que realizaran cada expresión tres veces más, manteniendo la pose facial durante tres segundos a la vez. Calificaron cada expresión para mayor comodidad, facilidad de uso y qué tan bien sintieron que la realizaron.

Crédito: Universidad de Glasgow

Las pruebas mostraron que siete faus que resaltaron diferentes áreas de la cara proporcionaban el equilibrio óptimo entre ser reconocido de manera confiable por los auriculares y ser cómodo para que los usuarios repitan regularmente. Estaban abriendo la boca; entrecerrando los ojos de la izquierda y derecha; Hinchando la mejilla izquierda y derecha y tirando de los bordes de la boca a cada lado.

El Dr. Graham Wilson, de la Escuela de Ciencias de la Computación de la Universidad de Glasgow, es uno de los autores del artículo. Él dijo: “Algunos han sugerido que la realidad virtual es una tecnología inherentemente capaz porque a menudo requiere que los usuarios realicen movimientos de mano hábiles con controladores o realicen movimientos de cuerpo completo que no todos pueden realizar cómodamente. Eso significa que, en este momento, hay barreras que impiden un acceso generalizado a las experiencias de realidad virtual y AR.

“Con este estudio, estábamos ansiosos por explorar si las funciones de un auricular de realidad virtual disponible comercialmente podrían adaptarse para ayudar a los usuarios a controlar con precisión el software usando solo su cara. Los resultados son alentadores y podrían ayudar a señalar nuevas formas de usar la tecnología no solo para las personas que viven con discapacidades sino también más ampliamente”.

Para probar la efectividad de los siete movimientos faciales que identificó el equipo, los investigadores construyeron su propio modelo de red neuronal para leer las expresiones capturadas por el Quest Pro con una precisión del 97%.

Luego, pidieron a 10 voluntarios no discapacitados que usen los auriculares para realizar dos tareas diferentes, que representan casos de uso futuros típicos para el sistema. Primero, los voluntarios usaron expresiones faciales para girar, seleccionar opciones y disparar armas en un entorno de juego de realidad virtual. Luego, usaron sus caras para desplazarse, seleccionar y navegar por páginas web en un entorno AR. En ambos casos, también utilizaron controladores VR de mano tradicionales para comparar las experiencias.

Los participantes informaron que, si bien los controladores ofrecían aportes más precisos para los juegos, el uso de expresiones faciales funcionó bien, ofreciendo un nivel útil de control sin requerir un esfuerzo excesivo. También encontraron que la experiencia de navegación web es simple e intuitiva, y mostraron una alta disposición a usar la entrada facial en el futuro.

Crédito: Universidad de Glasgow

El Dr. Mark McGill, coautor del documento de la Escuela de Ciencias de la Computación de la Universidad de Glasgow, dijo: “Este es un estudio relativamente pequeño, basado en datos capturados con la ayuda de personas no discapacitadas. Sin embargo,, sin embargo, muestra claramente que estos siete movimientos faciales específicos son probablemente el más fácil de recibir los métodos más fáciles.

“Eso nos da una base para construir en futuras investigaciones. Planeamos trabajar con personas con discapacidades como impedimentos motorizados o trastornos musculares en estudios adicionales para proporcionar a los desarrolladores y a las plataformas XR nuevas sugerencias de cómo pueden expandir su paleta de opciones de accesibilidad, y ayudarlos a liberarse de las restricciones de la información manual y del controlador”.

Las posibles aplicaciones de la investigación van más allá de expandir la accesibilidad. En el documento, los investigadores también destacan cómo habilitar a los auriculares utilizar el control de la expresión facial podría ayudar a los usuarios a realizar una variedad de tareas cotidianas. Sugieren que los usuarios podrían controlar las gafas AR mientras caminan con las manos llenas, mientras se cocinan, o al realizar tareas que requieren manos limpias. También podría ayudar a los usuarios un control más discreto de los dispositivos cuando se encuentran en espacios públicos.

El equipo también ha puesto en línea su conjunto de datos en línea para alentar a otros investigadores a explorar sus propios usos potenciales de las faus identificadas como la más útil para el control facial del software.

El documento del equipo, titulado “Interfaz: establecer un vocabulario de entrada de la unidad de acción facial para interacciones de realidad extendida manos libres, desde juegos de realidad virtual hasta navegación web AR”, se presentará en la Conferencia CHI en Yokohama, Japón, el lunes 28 de abril.

Más información: Interfaz: Establecer un vocabulario de entrada de la unidad de acción facial para interacciones de realidad extendida manos libres, desde juegos de realidad virtual hasta navegación web AR. www.alexandria.unisg.ch/entiti… E2-8236-B10602BDF965

Proporcionado por la Universidad de Glasgow

Cita: Las expresiones faciales podrían ayudar a ampliar las opciones de accesibilidad de realidad virtual y AR (2025, 7 de abril) Recuperado el 7 de abril de 2025 de https://techxplore.com/news/2025-04-facial-widen-vr-ar-acsability.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.