El sistema aprende después de ver videos de práctica

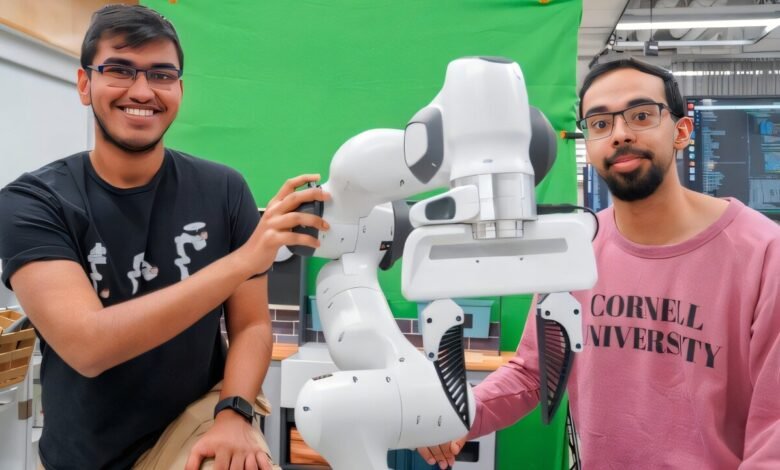

Kushal Kedia (izquierda), un estudiante de doctorado en el campo de la informática, y Prithwish Dan son miembros del equipo de desarrollo detrás de Rhyme, un sistema que permite a los robots aprender tareas viendo un solo video de instrucciones. Crédito: Louis DiPietro

Los investigadores de la Universidad de Cornell han desarrollado un nuevo marco robótico impulsado por la inteligencia artificial, llamada rima (recuperación de la imitación híbrida en una ejecución no coincidente), lo que permite a los robots aprender tareas viendo un solo video práctico.

Los robots pueden ser alumnos delicados. Históricamente, han requerido instrucciones precisas y paso a paso para completar las tareas básicas, y tienden a dejarlo cuando las cosas salen de la escritura, como después de dejar caer una herramienta o perder un tornillo. La rima, sin embargo, podría acelerar el desarrollo y el despliegue de sistemas robóticos al reducir significativamente el tiempo, la energía y el dinero necesarios para capacitarlos, dijeron los investigadores.

“Una de las cosas molestas de trabajar con robots es recopilar tantos datos sobre el robot que realiza diferentes tareas”, dijo Kushal Kedia, un estudiante de doctorado en el campo de la informática. “No es así como los humanos hacen tareas. Vimos a otras personas como inspiración”.

Kedia presentará un documento titulado “Imitación de un tiro bajo ejecución no coincidente”, en mayo en la Conferencia Internacional del Instituto de Ingenieros Eléctricos y Electrónicos sobre Robótica y Automatización, en Atlanta. El trabajo también está disponible en el servidor ARXIV Preprint.

Los asistentes de robot en el hogar siguen muy lejos porque carecen del ingenio para navegar por el mundo físico y sus innumerables contingencias. Para poner a los robots al día, investigadores como Kedia los están entrenando con lo que equivale a videos de cómo hacer: demostraciones humanas de varias tareas en un entorno de laboratorio. La esperanza de este enfoque, una rama del aprendizaje automático llamado “aprendizaje de imitación”, es que los robots aprenderán una secuencia de tareas más rápido y podrán adaptarse a los entornos del mundo real.

Crédito: Universidad de Cornell

“Nuestro trabajo es como traducir el francés al inglés: estamos traduciendo cualquier tarea dada de humano a robot”, dijo el autor principal Sanjiban Choudhury, profesor asistente de ciencias de la computación.

Sin embargo, esta tarea de traducción aún enfrenta un desafío más amplio: los humanos se mueven demasiado fluidamente para que un robot rastree e imite, y entrenar robots con video requiere un gour de él. Además, las manifestaciones de video, por ejemplo, recogiendo una servilleta o apilando las placas de cena, deben realizarse lenta y sin problemas, ya que cualquier desajuste en las acciones entre el video y el robot ha deletreado históricamente la fatalidad para el aprendizaje de los robots, dijeron los investigadores.

“Si un humano se mueve de una manera que es diferente de cómo se mueve un robot, el método se desmorona inmediatamente”, dijo Choudhury. “Nuestro pensamiento fue: ‘¿Podemos encontrar una forma de principios de lidiar con este desajuste entre cómo los humanos y los robots hacen tareas?'”

Rhyme es la respuesta del equipo, un enfoque escalable que hace que los robots sean menos llamativos y más adaptativos. Superada un sistema robótico para usar su propia memoria y conectar los puntos al realizar tareas que ha visto solo una vez dibujando en videos que ha visto. Por ejemplo, un robot equipado con rima mostró un video de un humano que busca una taza del mostrador y la colocó en un fregadero cercano peinará su banco de videos y se inspirará en acciones similares, como comprender una taza y bajar un utensilio.

La rima allana el camino para que los robots aprendan secuencias de múltiples pasos, al tiempo que reducen significativamente la cantidad de datos de robot necesarios para la capacitación, dijeron los investigadores. La rima requiere solo 30 minutos de datos de robot; En un entorno de laboratorio, los robots entrenados utilizando el sistema lograron un aumento de más del 50% en el éxito de la tarea en comparación con los métodos anteriores, dijeron los investigadores.

“Este trabajo es una desviación de cómo se programan los robots hoy. El status quo de programar robots es miles de horas de teleperación para enseñarle al robot cómo hacer tareas. Eso es simplemente imposible”, dijo Choudhury. “Con Rhyme, nos estamos alejando de eso y aprendiendo a entrenar a los robots de una manera más escalable”.

Junto con Kedia y Choudhury, los autores del periódico son Prithwish Dan, Angela Chao y Maximus Pace.

Más información: Kushal Kedia et al, imitación de un disparo bajo ejecución no coincidente, ARXIV (2024). Doi: 10.48550/arxiv.2409.06615

Información en la revista: ARXIV proporcionado por la Universidad de Cornell

Cita: Robot See, Robot Do: System aprende después de ver videos de cómo hacer (2025, 22 de abril) Recuperado el 22 de abril de 2025 de https://techxplore.com/news/2025-04-robot-videos.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.