El modelo dinámico puede generar movimientos humanos realistas y editar los existentes

Crédito: Jiang et al.

Al explorar su entorno, comunicarse con los demás y expresarse, los humanos pueden realizar una amplia gama de movimientos corporales. La capacidad de replicar de manera realista estos movimientos, aplicándolos a personajes humanos y humanoides, podría ser muy valiosa para el desarrollo de videojuegos y la creación de animaciones, contenido que se puede ver utilizando auriculares virtuales (VR) y videos de capacitación para profesionales.

Investigadores del Instituto de Inteligencia Artificial (IA) de la Universidad de Pekín y el Laboratorio Estatal de AI del General de IA recientemente introdujeron nuevos modelos que podrían simplificar la generación de movimientos realistas para personajes o avatares humanos. El trabajo se publica en el servidor ARXIV preimpresión.

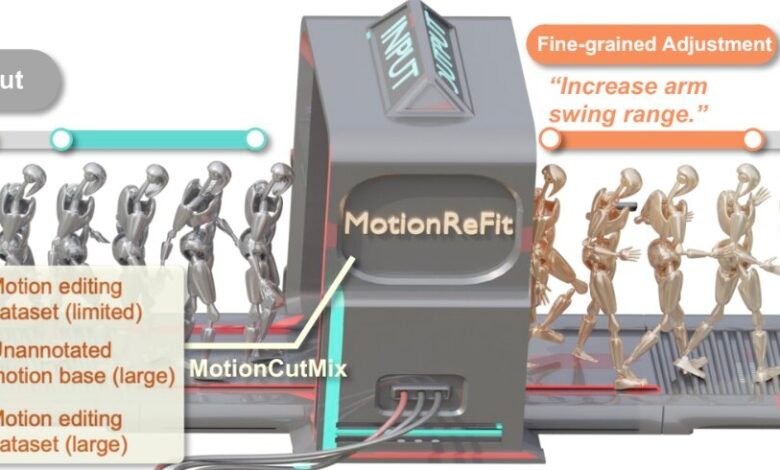

Su enfoque propuesto para la generación de movimientos humanos, descritos en un artículo presentado en CVPR 2025, se basa en una técnica de aumento de datos llamada MotionCutMix y un modelo de difusión llamado MotionRitf.

“Como investigadores que exploran la intersección de la inteligencia artificial y la visión por computadora, nos fascinó los avances recientes en la generación de texto a movimiento, sistemas que podrían crear movimientos humanos a partir de descripciones textuales”, dijo Yixin Zhu, autor principal del documento, a Tech Xplore.

“Sin embargo, notamos una brecha crítica en el paisaje tecnológico. Si bien la generación de movimientos desde cero había visto un progreso tremendo, la capacidad de editar los movimientos existentes se mantuvo severamente limitada”.

Los artistas, los desarrolladores de videojuegos y los cineastas de animación generalmente no crean un nuevo contenido completamente desde cero, sino que se inspiran en trabajos anteriores, refinándolos y ajustándolos hasta que obtengan los resultados deseados. Sin embargo, la mayoría de los sistemas de aprendizaje automático existente y de aprendizaje automático no están diseñados para admitir este flujo de trabajo creativo basado en edición e inspiración.

“Los sistemas desarrollados anteriormente que intentaban la edición de movimiento enfrentaron una restricción significativa, a saber, requerían trillizos extensivos precolectados de movimientos originales, movimientos editados e instrucciones correspondientes, datos extremadamente escasos y costosos de crear”, dijo Nan Jiang, coautor del documento. “Esto los hizo inflexibles, solo capaces de manejar escenarios de edición específicos en los que fueron entrenados explícitamente”.

El objetivo clave del estudio reciente de Zhu y sus colegas era crear un nuevo sistema que pudiera editar todas las mociones humanas basadas en las instrucciones escritas proporcionadas por los usuarios, sin la necesidad de entradas específicas de tareas o especificaciones del cuerpo.

Querían que este sistema apoyara ambos cambios en partes específicas del cuerpo (es decir, edición espacial) y la adaptación de los movimientos a lo largo del tiempo (es decir, edición temporal), generalizando bien en varios escenarios incluso cuando se entrenan en datos anotados limitados.

“MotionCutmix, el enfoque para el aprendizaje automático que ideamos, es una técnica de entrenamiento simple pero efectiva que ayuda a los sistemas de IA a aprender a editar movimientos humanos 3D basados en instrucciones de texto”, explicó Hongjie Li, coautor del documento.

“Del mismo modo a cómo los chefs pueden crear muchos platos diferentes mezclando y combinando ingredientes: MotionCutmix crea diversos ejemplos de entrenamiento al combinar partes del cuerpo de diferentes secuencias de movimiento”.

El enfoque de aprendizaje desarrollado por los investigadores puede seleccionar partes del cuerpo específicas (por ejemplo, los brazos de un personaje, las piernas, el torso, etc.) en una secuencia de movimiento, combinandolas con partes presentes en otra secuencia. En lugar de hacer la transición abruptamente de los movimientos de una parte del cuerpo a los de otro, MotionCutmix combina gradualmente los límites entre ellos, produciendo así movimientos más suaves.

“Por ejemplo, al combinar un movimiento de brazo de un movimiento con un torso de otro, interpola suavemente el área del hombro”, dijo Jiang. “Para cada movimiento combinado, crea un nuevo ejemplo de entrenamiento que consiste en una moción original, una versión editada de esa moción y una instrucción de texto que describe el cambio”.

La mayoría de los enfoques introducidos previamente para generar movimientos humanos fueron entrenados en conjuntos de datos fijos, que generalmente contenían videos anotados de personas que se mueven de diferentes maneras. Por el contrario, MotionCutMix puede generar nuevas muestras de entrenamiento sobre la marcha, lo que permite el aprendizaje de grandes bibliotecas de datos de movimiento que no necesita ser anotado manualmente.

Esto es ventajoso teniendo en cuenta que la mayoría del contenido que está disponible en línea no está anotado y, por lo tanto, no puede ser aprovechado por otros enfoques existentes. En particular, el nuevo marco desarrollado por los investigadores apoya tanto la edición de qué movimiento está realizando una parte de cuerpo específica (es decir, elementos semánticos) como cómo lo está haciendo (es decir, elementos estilísticos).

“MotionCutMix requiere muchos menos ejemplos anotados para lograr buenos resultados, creando potencialmente millones de variaciones de entrenamiento a partir de un pequeño conjunto de ejemplos etiquetados”, dijo Zhu.

“Al entrenar en diversas combinaciones de piezas y movimientos del cuerpo, el modelo aprende a manejar una gama más amplia de solicitudes de edición. A pesar de crear ejemplos de entrenamiento más complejos, no ralentiza significativamente el proceso de entrenamiento. El enmascaramiento suave y la coordinación de la parte del cuerpo crean movimientos editados más suaves y más naturales sin transiciones incómodas o movimientos irrealistas”.

Además del enfoque de aumento de datos de entrenamiento de MotionCutMix, Zhu y sus colegas desarrollaron un modelo de generación y edición de movimiento llamado MotionRitf. Si bien MotionCutMix se puede utilizar para crear una amplia gama de muestras de entrenamiento, MotionRfit es un modelo de difusión auto-regresiva que procesa estas muestras y aprende a generar y modificar los movimientos humanos.

En contraste con otros modelos de generación de movimiento humano, MotionRefit permite a los usuarios modificar con precisión las secuencias de movimientos humanos, simplemente describiendo los cambios que les gustaría hacer. Para el mejor conocimiento del equipo, su sistema es el primero que puede manejar las ediciones espaciales y temporales sin requerir entradas adicionales y especificaciones del usuario.

“En su núcleo, MotionRfit consiste en un modelo de difusión condicional auto-global que procesa el segmento de movimiento por segmento, guiado por las instrucciones originales de movimiento y texto”, explicó Ziye Yuan, coautor del documento.

“Este diseño supera las limitaciones clave de los enfoques anteriores, ya que funciona con movimientos de entrada arbitrarios e instrucciones de texto de alto nivel, sin necesidad de especificaciones explícitas de la parte del cuerpo. Mientras tanto, preserva la coordinación natural entre las partes del cuerpo al tiempo que hace cambios sustanciales en el movimiento, al tiempo que logran transiciones suaves tanto (entre regiones modificadas y no modificadas) y temporalmente (frames)”.

Los investigadores evaluaron su sistema propuesto en una serie de pruebas y descubrieron que la calidad de los movimientos humanos mejoró a medida que aumentaba la participación de la técnica de aumento de datos MotionCutmix. Esto confirmó su predicción de que exponer el modelo MotionRitf a una gama más amplia de combinaciones de movimiento durante el entrenamiento conduce a una mejor generalización en diferentes movimientos y escenarios.

Además, Zhu y sus colegas combinaron su técnica de aumento de datos con un modelo de referencia, llamado TMED. Sorprendentemente, descubrieron que MotionCutmix mejoró sustancialmente el rendimiento de este modelo, lo que sugiere que podría usarse para aumentar el aprendizaje de otras arquitecturas más allá de MotionRitf.

“A pesar de la introducción de ejemplos de entrenamiento más complejos, la convergencia de entrenamiento se mantiene incluso con altas proporciones de MotionCutmix”, dijo Zhu.

“Todas las variantes convergen dentro de 800k pasos, lo que indica que la técnica no crea una sobrecarga computacional significativa. Estos hallazgos demuestran colectivamente que MotionCutmix aborda un desafío fundamental en la edición de movimiento: la disponibilidad limitada de tripletes anotados, aprovechando los datos de movimiento existentes para crear variaciones de entrenamiento prácticamente ilimitadas a través de técnicas de composición inteligentes”.

En el futuro, la técnica de aumento de datos y el modelo de generación de movimiento humano desarrollado por este equipo de investigadores podrían usarse para crear y editar una amplia gama de contenido que presente caracteres humanos o humanoides. Podría ser una herramienta particularmente valiosa para animadores, desarrolladores de videojuegos y otros creadores de contenido de video.

“La edición de movimiento permite a los animadores iterar rápidamente en los movimientos de los personajes sin comenzar desde cero”, dijo Zhu.

“Los desarrolladores de juegos pueden generar extensas variaciones de movimiento a partir de datos capturados limitados, creando diversos comportamientos de NPC y animaciones de jugadores. La interacción humana-robot se puede mejorar al permitir que los robots ajusten sus movimientos en función de la retroalimentación del lenguaje natural. Los entornos de fabricación pueden ajustar los patrones de movimiento robóticos sin reprogramarse”.

El sistema creado por Zhu y sus colegas se basa en una interfaz basada en texto, por lo tanto, también es accesible para usuarios no expertos que no tienen experiencia con la creación de juegos o animaciones. En el futuro, podría adaptarse para su uso en la investigación en robótica, por ejemplo, como una herramienta para mejorar los movimientos de los robots de servicios humanoides.

“Desarrollar técnicas avanzadas de representación de movimiento que capturen mejor dependencias en secuencias más largas serán cruciales para manejar patrones temporales complejos”, agregó Jiang. “Esto podría implicar mecanismos de atención especializados para rastrear la consistencia en acciones secuenciales y modelos jerárquicos que entienden tanto los micro-movimientos como los patrones de nivel macro”.

Como parte de sus próximos estudios, los investigadores planean ampliar las capacidades de su sistema, por ejemplo, lo que le permite usar imágenes cargadas como referencias visuales y hacer ediciones basadas en demostraciones proporcionadas por los usuarios.

También les gustaría mejorar su capacidad para editar movimientos de manera que estén alineadas con las limitaciones ambientales y con el contexto en el que se realizan.

Más información: Nan Jiang et al, mezcla de movimiento dinámico para edición de movimiento versátil, ARXIV (2025). Doi: 10.48550/arxiv.2503.20724

Información en el diario: ARXIV

© 2025 Science X Network

Cita: el modelo dinámico puede generar movimientos humanos realistas y editar los existentes (2025, 13 de abril) recuperado el 13 de abril de 2025 de https://techxplore.com/news/2025-04-dynamic-generate-realistic-human-motions.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.