‘AI súper aturdida’ usa menos energía al imitar el cerebro humano

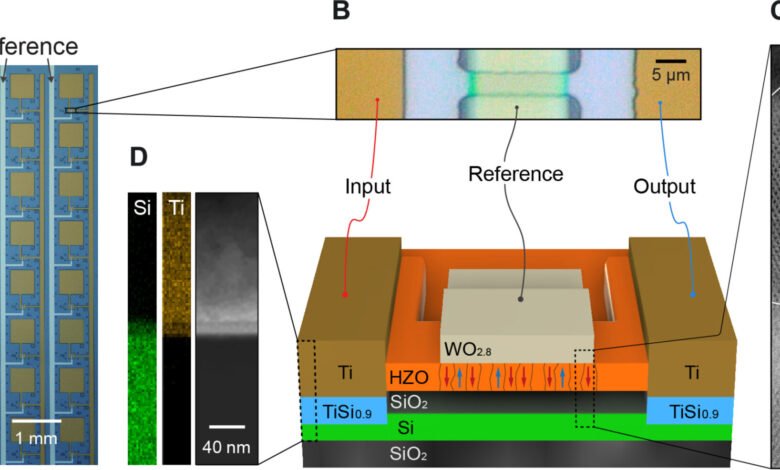

Estructura de un circuito sinstor. Crédito: avances científicos (2025). Doi: 10.1126/sciadv.adr2082

La inteligencia artificial (IA) puede realizar cálculos complejos y analizar datos más rápido que cualquier humano, pero hacerlo requiere enormes cantidades de energía. El cerebro humano también es una computadora increíblemente poderosa, pero consume muy poca energía.

A medida que las empresas de tecnología se expanden cada vez más, un nuevo enfoque para el “pensamiento” de la IA, desarrollado por investigadores, incluidos los ingenieros de la Universidad de Texas A&M, imita el cerebro humano y tiene el potencial de revolucionar la industria de la IA.

La Dra. Suin Yi, profesora asistente de ingeniería eléctrica e informática en la Facultad de Ingeniería de Texas A&M, se encuentra en un equipo de investigadores que desarrollaron “IA súper aturdida”, que funciona más como el cerebro humano. Esta nueva IA integra ciertos procesos en lugar de separarlos y luego migrar grandes cantidades de datos como lo hacen los sistemas actuales.

El “Turing” en el nombre del sistema se refiere al pionero de AI Alan Turing, cuyo trabajo teórico a mediados del siglo XX se ha convertido en la columna vertebral de la informática, la IA y la criptografía. Hoy, el más alto honor en Ciencias de la Computación se llama Premio Turing.

El equipo publicó sus hallazgos en avances científicos.

La crisis energética en la IA

Los sistemas de IA de hoy, incluidos modelos de idiomas grandes como OpenAI y ChatGPT, requieren una inmensa potencia informática y se encuentran en centros de datos expansivos que consumen grandes cantidades de electricidad.

“Estos centros de datos consumen poder en Gigawatts, mientras que nuestro cerebro consume 20 vatios”, explicó Suin. “Eso es mil millones de vatios en comparación con solo 20. Los centros de datos que consumen esta energía no son sostenibles con los métodos de computación actuales. Por lo tanto, si bien las habilidades de IA son notables, el hardware y la generación de energía necesarios para sostenerla todavía se necesitan”.

La energía sustancial exige no solo escalar los costos operativos, sino también aumentar las preocupaciones ambientales, dada la huella de carbono asociada con los centros de datos a gran escala. A medida que AI se vuelve más integrada, abordar su sostenibilidad se vuelve cada vez más crítica.

Emulando el cerebro

Yi y su equipo creen que la clave para resolver este problema radica en la naturaleza, específicamente, los procesos neuronales del cerebro humano.

En el cerebro, las funciones del aprendizaje y la memoria no están separadas, están integradas. El aprendizaje y la memoria dependen de las conexiones entre las neuronas, llamadas “sinapsis”, donde se transmiten señales. El aprendizaje fortalece o debilita las conexiones sinápticas a través de un proceso llamado “plasticidad sináptica”, formando nuevos circuitos y alterando los existentes para almacenar y recuperar información.

Por el contrario, en los sistemas informáticos actuales, la capacitación (cómo se enseña la IA) y la memoria (almacenamiento de datos) ocurren en dos lugares separados dentro del hardware de la computadora. La IA súper aburse es revolucionaria porque une esta brecha de eficiencia, por lo que la computadora no tiene que migrar enormes cantidades de datos de una parte de su hardware a otra.

“Los modelos de IA tradicionales dependen en gran medida de la backpropagation, un método utilizado para ajustar las redes neuronales durante el entrenamiento”, dijo Yi. “Si bien es efectiva, la backpropagation no es biológicamente plausible y es computacionalmente intensiva.

“Lo que hicimos en ese documento es solucionar la inverosimilitud biológica presente en los algoritmos de aprendizaje automático prevaleciente”, dijo. “Nuestro equipo explora mecanismos como el aprendizaje hebbiano y la plasticidad dependiente de la picos, procesos que ayudan a las neuronas a fortalecer las conexiones de una manera que imita cómo aprenden los cerebros reales”.

Los principios de aprendizaje hebbiano a menudo se resumen como “celdas que se disparan, se conectan”. Este enfoque se alinea más estrechamente con la forma en que las neuronas en el cerebro fortalecen sus conexiones en función de los patrones de actividad. Al integrar tales mecanismos inspirados biológicamente, el equipo tiene como objetivo desarrollar sistemas de IA que requieran menos potencia computacional sin comprometer el rendimiento.

En una prueba, un circuito que usa estos componentes ayudó a un dron a navegar por un entorno complejo, sin capacitación previa, aprendiendo y adaptando la marcha. Este enfoque fue más rápido, más eficiente y usó menos energía que la IA tradicional.

Por qué esto importa para el futuro de la IA

Esta investigación podría cambiar el juego para la industria de la IA. Las empresas están corriendo para construir modelos IA más grandes y potentes, pero su capacidad para escalar está limitada por las limitaciones de hardware y energía. En algunos casos, las nuevas aplicaciones de IA requieren construir nuevos centros de datos completos, aumentando aún más los costos ambientales y económicos.

Yi enfatiza que la innovación en el hardware es tan crucial como los avances en los sistemas de IA. “Muchas personas dicen que la IA es solo una cosa de software, pero sin calcular hardware, la IA no puede existir”, dijo.

Mirando hacia el futuro: desarrollo sostenible de IA

La IA súper cuidadosa representa un paso fundamental hacia el desarrollo sostenible de la IA. Al reinventar las arquitecturas de IA para reflejar la eficiencia del cerebro humano, la industria puede abordar los desafíos económicos y ambientales.

Yi y su equipo esperan que su investigación conduzca a una nueva generación de IA que es más inteligente y más eficiente.

“La IA moderna como el chatgpt es increíble, pero es demasiado costoso. Vamos a hacer una IA sostenible”, dijo Yi. “La IA súper aturdida podría remodelar cómo se construye y usa la IA, asegurando que a medida que continúe avanzando, lo hace de una manera que beneficia tanto a las personas como al planeta”.

Más información: Jungmin Lee et al, Circuito de resistencia sináptica basado en HFZRRO para un sistema inteligente súper aturdido, los avances científicos (2025). Doi: 10.1126/sciadv.adr2082

Proporcionado por la Universidad de Texas A&M

Cita: ‘Super-Turing Ai’ usa menos energía al imitar el cerebro humano (2025, 26 de marzo) recuperado el 26 de marzo de 2025 de https://techxplore.com/news/2025-03-super-turing-ai-energy-mimicking.html

Este documento está sujeto a derechos de autor. Además de cualquier trato justo con el propósito de estudio o investigación privada, no se puede reproducir ninguna parte sin el permiso por escrito. El contenido se proporciona solo para fines de información.